[HFR] Actu : AMD annonce Polaris, sa future architecture GPU

Actu : AMD annonce Polaris, sa future architecture GPU [HFR] - HFR - Hardware

Marsh Posté le 04-01-2016 à 15:36:10 5

De l'annonce, de l'annonce. On veut du concret nous monsieur Amédé.

Merci pour ce très bon article Damien ![]()

Marsh Posté le 04-01-2016 à 15:36:40 3

si nvidia a toujours eu pour habitude de teaser à l'avance sur leurs futures archi

c'est pas du tout le cas d'amd qui a plutôt tendance à cultiver l'art du secret jusqu'au dernier moment

étrange changement de stratégie de leurs part

reste à savoir si ils cherchent juste à rassurer les actionnaires qui ne se sont pas encore pendus , ou si ils croient vraiment dur comme fer en leur novelle archi

bon j'ai quand même envie de dire "allez les rouges "

Message édité par le 04-01-2016 à 15:45:51

Marsh Posté le 04-01-2016 à 15:47:38 1

| Citation : Enfin, AMD mentionne un Primitive Discard Accelerator, soit un système d'éjection des triangles masqués du pipeline de rendu. Pour rappel, statistiquement, à peu près la moitié des triangles d'un objet tournent le dos à la caméra et peuvent être éjectés du rendu dès que cet état est confirmé. Pouvoir le faire rapidement permet de booster les performances géométriques en situation réelle. |

C'est pas 3DFX qui avait utilisé un truc similaire juste avant son rachat par nvidia ?

Marsh Posté le 04-01-2016 à 15:47:44 4

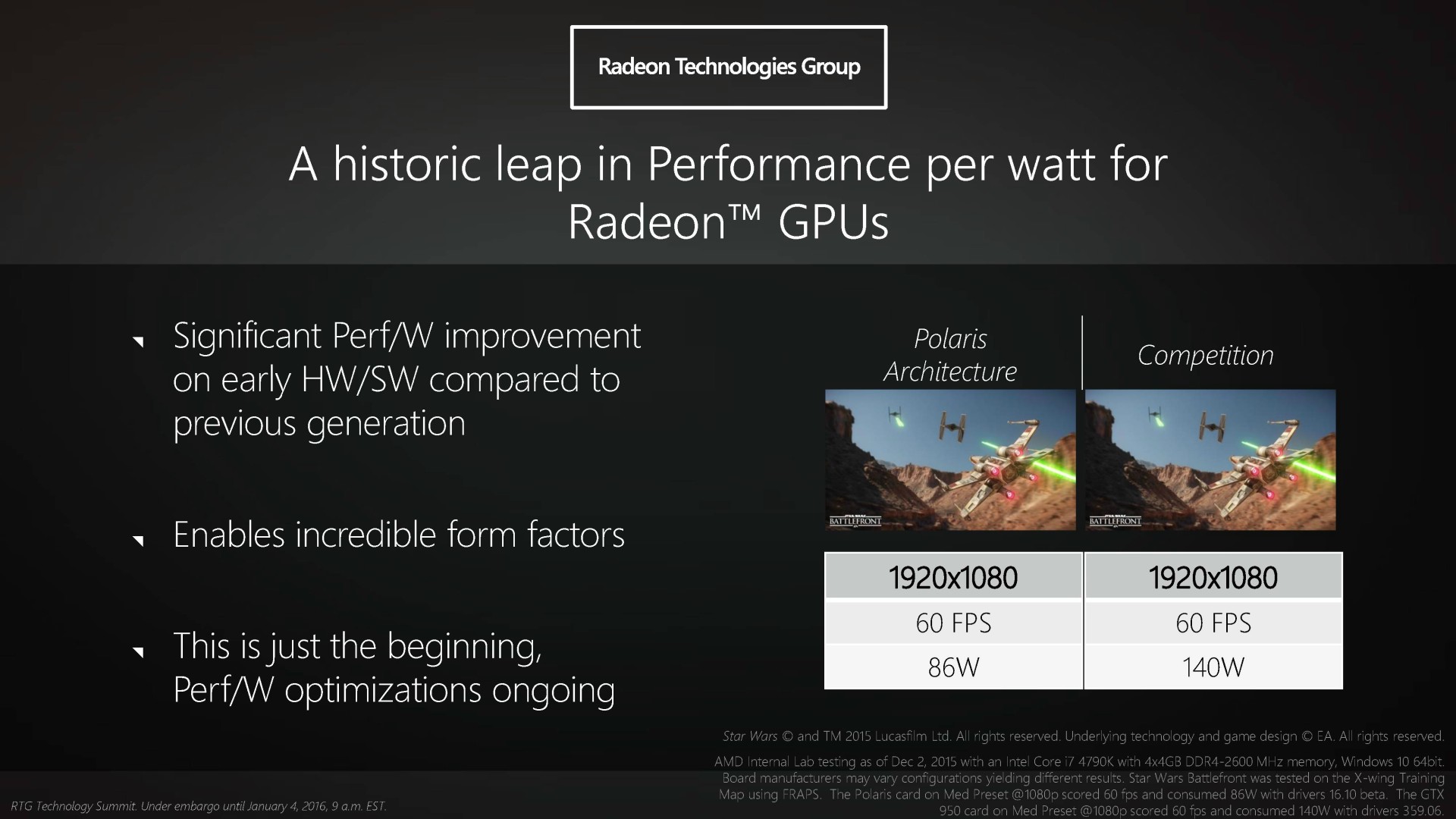

Le troisième dernier slide m'a fait pleurer (test sur Star Wars):

60 fps @ med preset en full HD : 86 W (Intel Core i7 4790k + Polaris card)

60 fps @ med preset en full HD : 140 W (Intel Core i7 4790k + NVIDIA GTX 950)

Pourquoi des Core i7, bande de traîtres !

Marsh Posté le 04-01-2016 à 15:50:15 0

| Moumoule a écrit : Le troisième dernier slide m'a fait pleurer (test sur Star Wars): |

Pas sûr qu'ils arrivent à tenir 60 fps avec leur CPU mobile. D'autant qu'ils ont tous un GPU intégré donc il aurait fallut l'enlever ^^

Marsh Posté le 04-01-2016 à 15:56:11 2

Ils ont peut être finit par comprendre qu'un marcher de niche ne suffit pas pour faire de beau bénéfice.

Donc faut bien faire du marketing pour signer des contrats juteux par la suite ![]()

---------------

Made you your own sentence without believing that of the others...

Marsh Posté le 04-01-2016 à 15:58:27 2

2017 s'annonce sympa, un ptit upgrade ZEN + Polaris milieu de gamme histoire de passer chez les rouges... ![]()

---------------

BOOM

Marsh Posté le 04-01-2016 à 16:01:32 1

Pas tant que ça. ![]()

Présentation de GCN à l'AFDS en juin 2011 pour une sortie sous la forme de Tahiti fin décembre de la même année.

Marsh Posté le 04-01-2016 à 16:03:55 1

Très bon article, j'attend aussi de voir ce que ça va donner maintenant et qui sait, peut-être changer ma 780Ti.

Marsh Posté le 04-01-2016 à 16:07:24 2

the_bob a écrit :

|

ça me fait plutôt penser à la techno utilisée par STmicro avec la kyiro 2 ![]()

Marsh Posté le 04-01-2016 à 16:09:14 2

Un article au top comme toujours !

Hâte de voir ce que cela va donner !

Marsh Posté le 04-01-2016 à 16:12:16 0

| aliss a écrit : |

c'est vrai j'avais zappé ça ![]()

mais bon , c'est vraiment pas arrivé souvent

et ça pourrait même sous entendre qu'ils ne le font que lorsqu'ils croient en leur produit ![]()

bon signe ou pas , on verra ![]()

Marsh Posté le 04-01-2016 à 16:13:13 1

the_bob a écrit :

|

Ils avaient une optimisation software pour éjecter certains types de primitives masquées. Depuis lors tous les GPU sont capables d'éjecter des primitives du rendu, la différence c'est la vitesse à laquelle ils peuvent le faire.

Par exemple :

Le GPU Fiji peut éjecter 4 triangles par cycle ou rendre 4 triangles par cycle.

Le GPU GM200 peut éjecter 12 triangles par cycle ou rendre 6 triangles par cycle.

Du coup si on imagine que 50% des triangles sont masqués, ça nous fait une moyenne de 9 triangles par cycle pour le GM200 contre seulement 4 pour Fiji.

Message édité par tridam le 04-01-2016 à 16:15:02

Marsh Posté le 04-01-2016 à 16:17:48 0

salut

Leur petite carte qu'il parle va peux etre me permettre de changer ma radeon hd 7750 ?

Si oui je vais la prendre si elle est dans les 130euro et moins et qu'elle consomme réellement 86w

sogetel20

---------------

demi gameur Phenom Ii x6 1055T Deepcool Gammax 200T a 42 degres full

Marsh Posté le 04-01-2016 à 16:23:24 1

86w c'est la conso de la platforme complete en vsync 60fps

Marsh Posté le 04-01-2016 à 16:27:00 1

Huuuum, le retour (enfin!!!) d'une saine concurrence sur laptop HDG? ![]() Enfin du travail sur la partie tesselation! (un comble, vu l'âge de la tesselation chez AT...AMD

Enfin du travail sur la partie tesselation! (un comble, vu l'âge de la tesselation chez AT...AMD ![]() ) et un gros cache qui va bien?

) et un gros cache qui va bien? ![]() Allé, on y croit

Allé, on y croit ![]() (tiens, interessant de remarquer qu''AMD communique beaucoup sur les petits form factor en ce moment....les fury X et nano, le super sexy mais pas commercialisé projet quantum, et là laptops -fins de surcroit-, soit + de 50% du marché depuis un bail)

(tiens, interessant de remarquer qu''AMD communique beaucoup sur les petits form factor en ce moment....les fury X et nano, le super sexy mais pas commercialisé projet quantum, et là laptops -fins de surcroit-, soit + de 50% du marché depuis un bail)

Marsh Posté le 04-01-2016 à 16:27:07 0

tu veux dire CPU + GPU ?

ça me semble peu, les 140W "actuels" dont ils parlent semblent plutôt correspondre au GPU seul, comme une GTX960

---------------

BOOM

Marsh Posté le 04-01-2016 à 16:45:40 1

| Moumoule a écrit : 60 fps @ med preset en full HD : 86 W (Intel Core i7 4790k + Polaris card) |

En fait, je comprends vraiment pas ce slide.

86W avec un GPU, un 4790k et de la mémoire? Certes en poussant la charge CPU à fond, l'article de HFR indique un système montant à 140W. Si on regarde le test de la GTX950, la conso du GPU seul sur des jeux que je pense pas plus exigeants est de 90-110W.

Ces chiffres sont pas improbables, mais bizarres. Ça doit pas être la conso à la prise, mais ça semble pas la conso de la CG non plus (EDIT: ce qu'ils semblent indiquer, contrairement à l'article).

Dernier point, DDR4-2600 sur z97? Bon ça doit être une typo, mais du coup c'est de la DDR3 de compét' à 200€ ou plus. La config bien équilibrée.

Message édité par KrisKross le 04-01-2016 à 16:47:57

Marsh Posté le 04-01-2016 à 17:14:09 3

Parfait. Il va maintenant falloir vérifier les dires d'AMD et, surtout, voir ce que nVidia a dans ses cartons avec Pascal.

| Citation : En effet, il semble de plus en plus probable qu'AMD exploite principalement les process 14nm de GlobalFoundries et Samsung alors que Nvidia exploiterait plutôt le 16nm de TSMC. Si l'un de ces process s'avère meilleur que l'autre, le fabricant de GPU qui aura misé sur le bon cheval s'en trouvera mécaniquement avantagé même si le process ne fait pas tout. |

Est-ce qu'AMD peut toujours dire non à GF vu les pénalités inhérentes à leur contrat d'utilisation de wafers et partir chez TSMC vu leur situation financière ? Est-ce qu'AMD peut toujours payer des pénalités vu sa santé financière très inquiétante ?

| Moumoule a écrit : Pourquoi des Core i7, bande de traîtres ! |

On parle d'efficacité énergétique là, donc bon Bulldozer et ses dérivés, à part faire plonger le ratio, je vois pas l'intérêt.

Message édité par Invite_Surprise le 04-01-2016 à 17:31:05

Marsh Posté le 04-01-2016 à 17:29:28 0

| aliss a écrit : |

ça nous ferrais une sortie de POLARIS pour Fin Juillet 2016 au plumareplus tard !!!

j'ai le sentiment que le 16nm FINFET de TSMC sera plus performant et chauffera mieux que le 14nm FINFET de grosflop et Samsung surtout pour Groflop.

Marsh Posté le 04-01-2016 à 17:31:57 0

lapin a écrit :

|

Qu' est-ce qui te fait penser ça ?

Marsh Posté le 04-01-2016 à 17:34:45 2

L ordonnancement statistique des cu permet-elle de les rendrent plus petit à gravure égal ?

La compression astc permet des économies de quel ordre ?

Marsh Posté le 04-01-2016 à 17:36:39 1

| Moumoule a écrit : Le troisième dernier slide m'a fait pleurer (test sur Star Wars): |

C'est vrai que c'est amusant qu'ils fassent des tests avec des CPU Intel ![]()

Mais j'imagine que tester avec un FX9590 (le plus puissant de leur gamme) aurait fait exploser la consommation...

Marsh Posté le 04-01-2016 à 17:40:48 0

ReplyMarsh Posté le 04-01-2016 à 17:44:38 0

| Lyto a écrit :

|

ben début juin 2011 à fin décembre 2011 ça fait 7 mois, là on est début Janvier 2016, donc si je prend en compte 7 mois ça fait fin juillet 2016, de toute façon je les vois mal louper septembre 2016 et encore moins novembre 2016.

Message édité par lapin le 04-01-2016 à 17:48:56

Marsh Posté le 04-01-2016 à 17:47:49 1

| lulunico06 a écrit : L ordonnancement statistique des cu permet-elle de les rendrent plus petit à gravure égal ? |

un peut de tout mémoire et bande passante, pas contre le coût en transistor et en consommation GPU doit être important, ça dois bouffer des transistors en pré-cabler rien que pour ça et en bouffer un grande quantité, en tout cas ça ne sera pas gratuit tant en cycle d’horloge que de consommation énergétique.

avec ASTC tu peux te contenter de 4 GO même en affichage 4K.

Marsh Posté le 04-01-2016 à 17:51:30 3

C'est pas 3DFX qui avait utilisé un truc similaire juste avant son rachat par nvidia ? [/quotemsg]

ça me fait plutôt penser à la techno utilisée par STmicro avec la kyiro 2 ![]() [/quotemsg]

[/quotemsg]

quelle bonne carte la Kyro2 je l'ai encore qui traine sur une etagere j'ai pas reussi a la jetter ![]()

Marsh Posté le 04-01-2016 à 17:54:18 0

tridam a écrit :

|

il me semble bien que le tile rendering des Kyro I et II c'etait hardware mais je vais verif

Marsh Posté le 04-01-2016 à 17:55:37 1

| Citation : le FinFET se détache de la construction planaire classique des transistors en donnant une troisième dimension à la porte ce qui permet d'en augmenter la surface de contact et de mieux l'isoler. Les courants de fuite, qui peuvent représenter une grosse partie de la consommation d'un transistors classique, sont alors nettement réduits. |

Les courants de fuite ne sont responsables que de la consommation résiduelle.

Finfet est utilisé pour diminuer la tension nécessaire pour générer un même champ électrique, et donc diminuer la consommation électrique par effet joule.

Marsh Posté le 04-01-2016 à 17:57:46 0

alors la : http://www.hardware.fr/articles/31 [...] ering.html

y a ecrit ca :

| Citation : |

on dirait donc bien que ct du hardware

Message édité par c0rwin le 04-01-2016 à 17:58:56

Marsh Posté le 04-01-2016 à 18:04:03 6

Du coup, les nouveaux GPU sont froids comme des glaçons, de part la référence au Groënland, à l'étoile polaire. Les précédents faisant référence à des volcans, il s'avère que ce sont bel et bien des fournaises!

Marsh Posté le 04-01-2016 à 18:19:03 1

| c0rwin a écrit : |

ça me fait plutôt penser à la techno utilisée par STmicro avec la kyiro 2 ![]() [/quotemsg]

[/quotemsg]

quelle bonne carte la Kyro2 je l'ai encore qui traine sur une etagere j'ai pas reussi a la jetter ![]() [/quotemsg]

[/quotemsg]

Je me souviens de l'avoir achetée en meme temps que le jeu de stratégie Dune ![]()

j'en ai un bon souvenir, mais quand les jeux T&L ont commencé a être la norme, elle valait plus rien ![]()

Bon pour revenir au sujet, il n'y a pas déjà des technos similaires sur les cartes actuelles ?

---------------

BOOM

Marsh Posté le 04-01-2016 à 18:36:14 1

| bjone a écrit : Du coup la relation entre Polaris et Greenland ? |

Polaris ( GCN 4 ) c'est l'archi

Greenland c'est le flagship ( le plus gros GPU )

( en gros comme le GM200 c'est le flagship de l'archi Maxwell 2 )

Marsh Posté le 04-01-2016 à 19:32:51 0

| lapin a écrit : |

ben début juin 2011 à fin décembre 2011 ça fait 7 mois, là on est début Janvier 2016, donc si je prend en compte 7 mois ça fait fin juillet 2016, de toute façon je les vois mal louper septembre 2016 et encore moins novembre 2016.[/quotemsg]

My bad. J'aurais pas dû quoter le message en entier. Je te posais la question sur le procédé de gravure en fait. J'ai lu sur un site qu''en matière de conso, le procédé de gravure de Samsung avait l'air très performant. Du coup je me demandais ...

---------------

L'innovation, c'est extra :)

Marsh Posté le 04-01-2016 à 19:36:54 1

"Enfin, AMD mentionne un Primitive Discard Accelerator, soit un système d'éjection des triangles masqués du pipeline de rendu."

Enfin! En effet.

Marsh Posté le 04-01-2016 à 19:49:09 0

| Lyto a écrit : |

My bad. J'aurais pas dû quoter le message en entier. Je te posais la question sur le procédé de gravure en fait. J'ai lu sur un site qu''en matière de conso, le procédé de gravure de Samsung avait l'air très performant. Du coup je me demandais ...

[/quotemsg]

Regarde le soc des tout dernier iphone ceux gravé par TSMC chauffe moins que les samsung

Marsh Posté le 04-01-2016 à 20:11:59 2

| lulunico06 a écrit : L ordonnancement statistique des cu permet-elle de les rendrent plus petit à gravure égal ? |

On parle d'ordonnancement *statique* ![]() . Ça permet de réduire le nombre d'unités qui vont se charger de l'ordonnancement des instructions ou des différents compteurs qui servent à garantir la validité d'exécution. Sur Maxwell, c'est le compilateur qui détermine le nombre de cycles entre deux instructions et qui place des "marqueurs" pour les instructions qui ont une durée non fixée (scoreboards). C'est toujours ça de gagné au niveau matériel. Par contre, ça rend le compilateur plus complexe et ça peut poser des problèmes (comme sur Itanium, par exemple).

. Ça permet de réduire le nombre d'unités qui vont se charger de l'ordonnancement des instructions ou des différents compteurs qui servent à garantir la validité d'exécution. Sur Maxwell, c'est le compilateur qui détermine le nombre de cycles entre deux instructions et qui place des "marqueurs" pour les instructions qui ont une durée non fixée (scoreboards). C'est toujours ça de gagné au niveau matériel. Par contre, ça rend le compilateur plus complexe et ça peut poser des problèmes (comme sur Itanium, par exemple).

Marsh Posté le 04-01-2016 à 20:28:26 1

Le slide concernant la consommation est erroné, il y a écrit DDR4 alors que c'est de la 3 (i7 4790K pas compatible avec la DDR4).

AMD avait déjà utilisé un i7 4790K dans le projet quantum, ils savent très bien que les FX actuelles ne peuvent pas rivalisé contre les i5/i7 actuelles dans les jeux (ipc plus faible et performance sur un cur bien plus faible). J'ai envie de dire vivement ZEN, en même temps les cpu haut de gamme que AMD vend actuellement n'ont pas été remit à neuf depuis un moment.

Toujours concernant le slide, à la fin de la vidéo d'amd il y a plus de détail (https://www.youtube.com/watch?v=5g3eQejGJ_A).

Les 86 c'est la consommation total du système (oui oui sérieusement).

C'est pour ça que la GTX950 utilise 140W.

Les fps ont été bloqué sur 60 donc la carte ne tourne pas à fond. Le cpu non plus, sur la vidéo il précise même que sa consommation maximum à été réduit à 80% de la valeur d'origine.

On peut donc compter facilement 60 W pour le système (processeur + cm + ssd + ram) ce qui fait seulement 26 W pour la CG AMD et 80W pour la GTX950.

Une consommation 3x plus faible incroyable non ? Pourtant la fury x est en retrait en perf énergétique par rapport à la 980ti et AMD a promis une doublement de l'efficacité énergétique entre polatis et la génération actuel.

Alors comment AMD a pu arriver a un tel résultat ?

La réponse est toujours dans la vidéo, la GTX950 fonctionne avec ses fréquences d'origines alors que carte d'amd fonctionne 850MHz avec une tension de 0,8375V.

Avec une fréquence plus élevé (1200 MHz je pense qu'on pourra atteindre ça en 14nm) on serra plus sur du 2x mieux que maxwell que sur du 3x mieux.

En tout cas c'est prometteur, revoir AMD leader du perf/watt (comme à l'époque des radeon 4xxx et 5xxx ![]() ) ne serait pas une mauvaise chose.

) ne serait pas une mauvaise chose.

Après il faut voir la réponse de Nvidia. Pascal sera en 16 nm, donc la performance énergétique va aussi bien progresser.

Reste qu'AMD devrait avoir désormais l'avantage de la gravure. Le 14 LPE (low power earlier) de Samsung/Global Founderies était légèrement en retrait par rapport au 16 nm de TSMC (voir iphone 6S). Mais maintenant le 14 nm LPP (low power plus) est mature (et normalement c'est lui qui va être utilisé pour les GPU et CPU d'AMD) et ce dernier est meilleur que le 14 LPE (le seule slide de Samsung que j'ai trouvé indique "more performance, less power" mais ne donne pas de chiffre, sachant qu'il est plus abouti je doute qu'il sera derrière le 16 nm de TSMC).

Message édité par robin4002 le 04-01-2016 à 20:29:12

Sujets relatifs:

- Que Faire ? GPU Brider par le CPU ?

- Configuration 3 écrans AMD R9 290X

- AMD R7 360-Affichage en DVI impossible, hdmi ok

- [HFR] Actu : Bonne année 2016 !

- APU C60 AMD à 100%?

- [HFR] Focus : i5-6400 à 4.5 GHz, le retour de l'oc chez Intel ?

- Problème compatibilité XP pour AMD FM2 FM2+ chez Gigabyte

- Avis Sapphire Vapor-X HD 7950 OC ou SAPPHIRE AMD ATI Radeon R9 280 3G

- Changement GPU

Marsh Posté le 04-01-2016 à 15:16:22 3

Enfin, après 4 années de GCN en 28nm, les Radeon vont accueillir une nouvelle architecture gravée en 14nm : Polaris. Et pour AMD le focus se portera sur ...

Lire la suite ...