[HFR] Actu : Nvidia dévoile le GV100: 15 Tflops, 900 Go/s...

Actu : Nvidia dévoile le GV100: 15 Tflops, 900 Go/s... [HFR] - HFR - Hardware

Marsh Posté le 10-05-2017 à 22:51:44 1

Encore et toujours plus hauuuuuuuuuuuuuuuuuuut!

des chances de voir Volta dans nos petit PC tel la titan XP d'ici un an?

Message édité par schpounzzz le 10-05-2017 à 22:52:30

Marsh Posté le 10-05-2017 à 22:59:35 0

Dans leur présentation j'ai cru comprendre que les tensor core c'est des unités en plus dédiées au deep learning.

Un peu comme les unités en plus pour les dp.

Je me trompe ?

Marsh Posté le 10-05-2017 à 23:04:35 2

Vous débrieffez très bien, bravo!

Ça fait du bien sans le bla bla commercial.

En outre il est normal qu'entre leur futur Volta le dépassé Kepler, la marge de progression des résultats est folle.

Message édité par Flibidi le 10-05-2017 à 23:05:28

Marsh Posté le 10-05-2017 à 23:17:34 0

Tsmc annonce que le 12 nm c'est 20 % de gain de densité.

Du coup comment nvidia arrive à ne pas avoir de gain de densité ?

Marsh Posté le 10-05-2017 à 23:27:36 0

| lulunico06 a écrit : Dans leur présentation j'ai cru comprendre que les tensor core c'est des unités en plus dédiées au deep learning. |

Difficile de connaître l'implémentation exacte à ce point. Les graphes et termes employés sont toujours des figures d'esprit. En l’occurrence Nvidia veut ici insister sur l'importance donnée au deep learning.

Marsh Posté le 10-05-2017 à 23:27:49 2

| lulunico06 a écrit : Tsmc annonce que le 12 nm c'est 20 % de gain de densité. |

Optimiser la dissipation de chaleur

Marsh Posté le 10-05-2017 à 23:30:52 2

| lulunico06 a écrit : Tsmc annonce que le 12 nm c'est 20 % de gain de densité. |

Nvidia parle d'un 12 nm FFN personnalisé pour ses besoins. La densité moindre permet peut-être de limiter la consommation ou d'éviter que le dégagement de chaleur par unité de surface ne soit problématique. C'est possible également que les interfaces mémoire et particulièrement NV-Link occupent beaucoup de place sur le GV100 et ne scalent pas très bien.

Marsh Posté le 10-05-2017 à 23:42:10 0

| ravenloft a écrit : Comme c'est les 20 ans d'HFR, question : le gv100 en flops c'est combien de fois plus puissant qu'une voodoo 1? |

Elle n'est pas sortie ça compte po ![]()

Marsh Posté le 10-05-2017 à 23:53:26 1

815 mm² ![]()

Ça doit coûter un bras de fabriquer un tel GPU !

En tout cas je pense pas qu'on soit prêt de voir un GPU de ce genre pour le grand public.

Ça m'étonnerai d'ailleurs qu'on voit une déclinaison grand public de Volta avant 2018.

Message édité par Xillendo le 10-05-2017 à 23:54:14

Marsh Posté le 10-05-2017 à 23:55:16 0

| lulunico06 a écrit : Tsmc annonce que le 12 nm c'est 20 % de gain de densité. |

Easy : c'est la surface totale GPU + HBM2 qui est donnée ![]()

Marsh Posté le 11-05-2017 à 00:28:46 0

Putain ce monstre, voila ce que sera la GTX 2080 Ti / Titan Volta...

...Et ce que devrait etre la GTX 2080 ![]()

La seule chose qui pourrait changer par rapport a ces cartes Tesla, c'est la RAM qui sera soit de la GDDR5X, soit de la GDDR6.

...A moins que Vega rattrape nVidia dans les hautes resolutions, au quel cas nVidia gardera l'usage de l'HBM2.

N'empeche, un bus 4096 bits au lieu de 2048 pour de l'HBM2, je sais pas ce qui empeche AMD de faire comme nVidia.

Ceci dit, l'HBM2 c'est bien, mais je crois pas que ca fasse si mieux que de la GDDR5x voire GDDR6 en bus 512 bits; le cout et la complexite de l'HBM2 en moins.

D'ailleurs ca fait quand meme assez longtemps qu'on a pas eu un bus 512 bits (R9 390X, GTX 280 !) alors qu'ils sont certainement capables de faire un bus 768 bits ou 1024 bits pour de la VRAM conventionnelle aujourd'hui...

Pendant ce temps la, toujours pas de carte graphique ne consommant pas plus de 25 Watts en single slot + low profile; alors que Maxwell et Pascal ont fait des pas sur la consommation... ![]()

C'est pas comme si le marche de l'automotive se developpait, et que ca rentre dans un de leur business... ![]()

Message édité par Crosslink le 11-05-2017 à 07:52:30

Marsh Posté le 11-05-2017 à 00:36:03 1

ReplyMarsh Posté le 11-05-2017 à 01:13:47 0

Vu que la densité n'a pas beaucoup bougé, on aura peut être droit à un GV104 proche des 400-450mm² et un GV102 autour de 600-650mm² en restant sur une conso similaire aux produits actuels ? La valeur Tflops/mm² n'évoluant que de 5%, il va falloir jouer sur la taille du die non ?

Marsh Posté le 11-05-2017 à 01:21:14 1

| sebaas a écrit : olala on va pouvoir jouer en 8k detail mini surement |

C'est vrai que ça fait rêver les détails mini ![]()

Marsh Posté le 11-05-2017 à 01:49:35 0

| ravenloft a écrit : Comme c'est les 20 ans d'HFR, question : le gv100 en flops c'est combien de fois plus puissant qu'une voodoo 1? |

Ben deja la question c'etait pour des cartes nVidia uniquement... Et Volta n'est pas encore sorti de toutes facons.

Marsh Posté le 11-05-2017 à 02:28:21 1

| Crosslink a écrit : Putain ce monstre, voila ce que sera la GTX 2080 Ti / Titan Volta... |

Hum non, le GV100 ne se retrouvera jamais dans une Titan ou encore moins une Geforce, c'est comme avec le GP100, qui n'a jamais été décliné en geforce/titan.

Comme le pressent Invite_Surprise, Volta "grand publique" ça sera GV102/104 et plus petit, des puces moins imposantes, dans les 600 mm² pour le GV102 et autour des 400 mm² pour le GV104.

Message édité par havoc_28 le 11-05-2017 à 02:40:25

Marsh Posté le 11-05-2017 à 07:19:44 0

Si on ne prend en compte que le core count, je ne vois pas en quoi ca ne se retrouvera pas dans une Titan ou GeForce:

Kepler (2880 C): Tesla K40 (GK110B) -> GTX 780 Ti / GTX Titan Black (GK110)

Maxwell (3072 C): Tesla M40 (GM200) -> GTX Titan X (GM200)

Pascal (3840 C): Tesla P40 (GP102) -> GTX Titan XP (GP102)

Exception faite des GTX 980 Ti (GM200) et GTX 1080 Ti / GTX Titan X (GP102) qui sont des versions amputees des GPU complets (defects ou trucides au laser), ca a toujours ete decline pour le "grand public".

Apres, il se peut que sa fasse comme pour Pascal, ou le GP102 est plus gros -en core count- qu'un GP100 -ou alors ce dernier etait un defect non avoue de ce qu'est le GP102, qui aurait lui-meme du etre le GP100 a la base-.

En considerant ce dernier point, plus ce qu'a dit Invite_Surprise; soit on aura un GPU plus petit comme il a dit -et ce, meme au niveau du core count-, soit plus gros que GV100.

Message édité par Crosslink le 11-05-2017 à 08:36:37

Marsh Posté le 11-05-2017 à 07:43:31 0

| Crosslink a écrit : |

Je ne sais pas si c'est un peu prématuré mais la GT 1030 ne devrait pas tarder, surement des performances proches ou supérieures à une GTX 750 Ti pour la moitié de la consommation (60W => 30W)

Marsh Posté le 11-05-2017 à 07:57:11 0

Ca parle de 35W pour la GTX 1030, c'est malheureusement 10W de trop ![]()

Une partie des cartes meres pour automotive sont du Thin ITX, dont ils ont eu la connerie de limiter le port PCIe x16 a 25W... alors qu'ils auraient du laisser le choix de la carte fille determiner elle-meme la consommation.

Message édité par Crosslink le 11-05-2017 à 07:58:37

Marsh Posté le 11-05-2017 à 08:02:38 1

| Crosslink a écrit : Si on ne prend en compte que le core count, je ne vois pas en quoi ca ne se retrouvera pas dans une Titan ou GeForce: Kepler (2880 C): Tesla K40 (GK110B) -> GTX 780 Ti / GTX Titan Black (GK110) Maxwell (3072 C): Tesla M40 (GM200) -> GTX Titan X (GM200) Pascal (3840 C): Tesla P40 (GP102) -> GTX Titan XP (GP102)

Apres, il se peut que sa fasse comme pour Pascal, ou le GP102 est plus gros qu'un GP100 -ou alors ce dernier etait un defect non avoue d'un die plus gros encore-.

|

Heu, les 1080 Ti, Titan X, Titan XP c'est du GP102 (980Ti GM200).

Le GP102 fait 470mm2, le GP100 610mm2.

Message édité par aliss le 11-05-2017 à 08:04:03

Marsh Posté le 11-05-2017 à 08:15:50 0

My bad pour ton premier surlignage, je vais corriger ca.

Sinon je ne parle que de core count (cf premiere phrase), pas de la surface totale du die vu qu'il y a effectivement des parties charcutees pour les GPU "grand public" -qui sont inutiles pour le gaming-.

Toujours que en core count, le GP 100 (Tesla P100; 3584 C) reste donc plus petit que GP 102 du GTX Titan XP (3840 C).

Message édité par Crosslink le 11-05-2017 à 08:19:23

Marsh Posté le 11-05-2017 à 08:28:22 0

Question :

Pourquoi "d'habitude" les GPUs font moins de 600mm2 ?

Et qu'est-ce qui permet à NVIDIA de sortir un si gros GPU ?

Marsh Posté le 11-05-2017 à 08:32:59 0

Dans un premier cas, le refroidissement en salle blanche qui ne connait pas de limites niveau bruit -et donc de ventilation-.

Du coup, ca permet de refroidir correctement les parties charcutees sur "cartes grand public", et la double precision qui dans ce dernier cas subit un bridage de frequence -car ca consomme plus qu'en simple precision-.

D'un autre cote, simplement la surface prise par la VRAM.

Troisieme cas aussi, ca autorise un meilleur yield, plus rentable.

Message édité par Crosslink le 11-05-2017 à 08:46:09

Marsh Posté le 11-05-2017 à 09:32:46 0

| Crosslink a écrit : |

Le GP100 utilise un chip castré, et est capable de double précision contrairement au GP102 de plus son agencement est différent, il utilise des SM de 64 unités et non 128 unités.

http://www.hardware.fr/tag_flux/12 [...] actu_14577

Même histoire pour le V100 qui utilise le même type de configuration avec des SM de 64 unités.

http://www.hardware.fr/articles/94 [...] 16-nm.html

voir : "GP104 : SM, Pascal G et Pascal T"

Message édité par havoc_28 le 11-05-2017 à 09:38:42

Marsh Posté le 11-05-2017 à 10:18:48 0

| Asthon a écrit : Je ne sais pas si c'est un peu prématuré mais la GT 1030 ne devrait pas tarder, surement des performances proches ou supérieures à une GTX 750 Ti pour la moitié de la consommation (60W => 30W) |

Pour info, la GTX 750 Ti, c'est 38W en réel, pas 75W. La future 1030 se place pil poil dans cette ligne.

Message édité par HashBoost le 11-05-2017 à 10:19:09

Marsh Posté le 11-05-2017 à 10:21:03 1

| Crosslink a écrit : Une partie des cartes meres pour automotive sont du Thin ITX, dont ils ont eu la connerie de limiter le port PCIe x16 a 25W... alors qu'ils auraient du laisser le choix de la carte fille determiner elle-meme la consommation. |

Pour l'embarqué, NVidia a d'autres solutions adaptées, a base de Tegra. Je ne vois absolument pas ce que tu cherches avec tes 30W.

Marsh Posté le 11-05-2017 à 10:24:24 0

150.000$ le serveur, mince je vais être un peu juste ^^

---------------

New Technology is the name we give to stuff that doesn't work yet. Douglas Adams

Marsh Posté le 11-05-2017 à 10:33:03 1

| Crosslink a écrit : Ca parle de 35W pour la GTX 1030, c'est malheureusement 10W de trop |

T'as besoin d'une CG puissante pour du "automotive" pour faire quoi au juste ?

Les fabricants auto ne peuvent-ils pas simplement demander à nvidia de leur produire/certifier une version underclockée avec un TDP à 25W ?

---------------

New Technology is the name we give to stuff that doesn't work yet. Douglas Adams

Marsh Posté le 11-05-2017 à 10:34:08 0

| Crosslink a écrit : Si on ne prend en compte que le core count, je ne vois pas en quoi ca ne se retrouvera pas dans une Titan ou GeForce: |

Heu là on parle de GPU @ US$18K ... ![]()

AMHA on va avoir un GV104 (sans tensor core, avec un débit FP64 moindre) @ 3584SP @ ~1,8GHz ... ce qui serait déjà bien et pourrai donner une GTX 2080 ~> Titan Xp ...

---------------

| AMD Ryzen 7 7700X 8C/16T @ 4.5-5.4GHz - 64GB DDR5-6000 30-40-40 1T - AMD Radeon RX 7900 XTX 24GB @ 2680MHz/20Gbps |

Marsh Posté le 11-05-2017 à 10:35:57 0

| MEI a écrit : |

Un peu gros ton GV104...

Marsh Posté le 11-05-2017 à 10:38:31 0

| havoc_28 a écrit : |

Un GP104 fait déjà 2560 SP ... en passant de 16nm à 12nm si on gagne pas au moins la moitié en SP c'est pas la peine, autant continuer à vendre des GP102...

---------------

| AMD Ryzen 7 7700X 8C/16T @ 4.5-5.4GHz - 64GB DDR5-6000 30-40-40 1T - AMD Radeon RX 7900 XTX 24GB @ 2680MHz/20Gbps |

Marsh Posté le 11-05-2017 à 10:44:33 0

| MEI a écrit : |

Comme déjà fait remarqué plus haut la densité n'augmente quasiment pas en passant de 16 à 12 nm ...

| Citation : Malgré le passage au 12 nm, la densité ne progresse presque pas et le GV100 est énorme avec 815 mm² contre 610 mm² pour le GP100. Le 12 nm permet ici avant tout de pouvoir monter en puissance à consommation similaire |

.

Dans l'article de tridam.

Message édité par havoc_28 le 11-05-2017 à 10:45:40

Marsh Posté le 11-05-2017 à 11:08:16 0

| havoc_28 a écrit :

. |

Ouai enfin, ça reste un poil plus dense à minima. Sachant qu'un GP102 est quand même dans des produits @ ~850€, du GV104 avec le même nombre de SP, mais en 256 bits et donc avec une organisation des SM un peu différente, devrais facilement à ~400mm² (là ou un GP104 est a ~310mm² et un GP102 a ~470m²).

Avec 8Go de RAM GDDR5X on devrais avoir des perfs @ 1080Ti/Titan Xp pour un prix encore moindre (disons ~649€ ![]() ).

).

Ça fait un peu devins, mais AMHA, c'est ça ou 3072 SP cloqué a 2-2,2GHz... ![]()

---------------

| AMD Ryzen 7 7700X 8C/16T @ 4.5-5.4GHz - 64GB DDR5-6000 30-40-40 1T - AMD Radeon RX 7900 XTX 24GB @ 2680MHz/20Gbps |

Marsh Posté le 11-05-2017 à 11:19:26 1

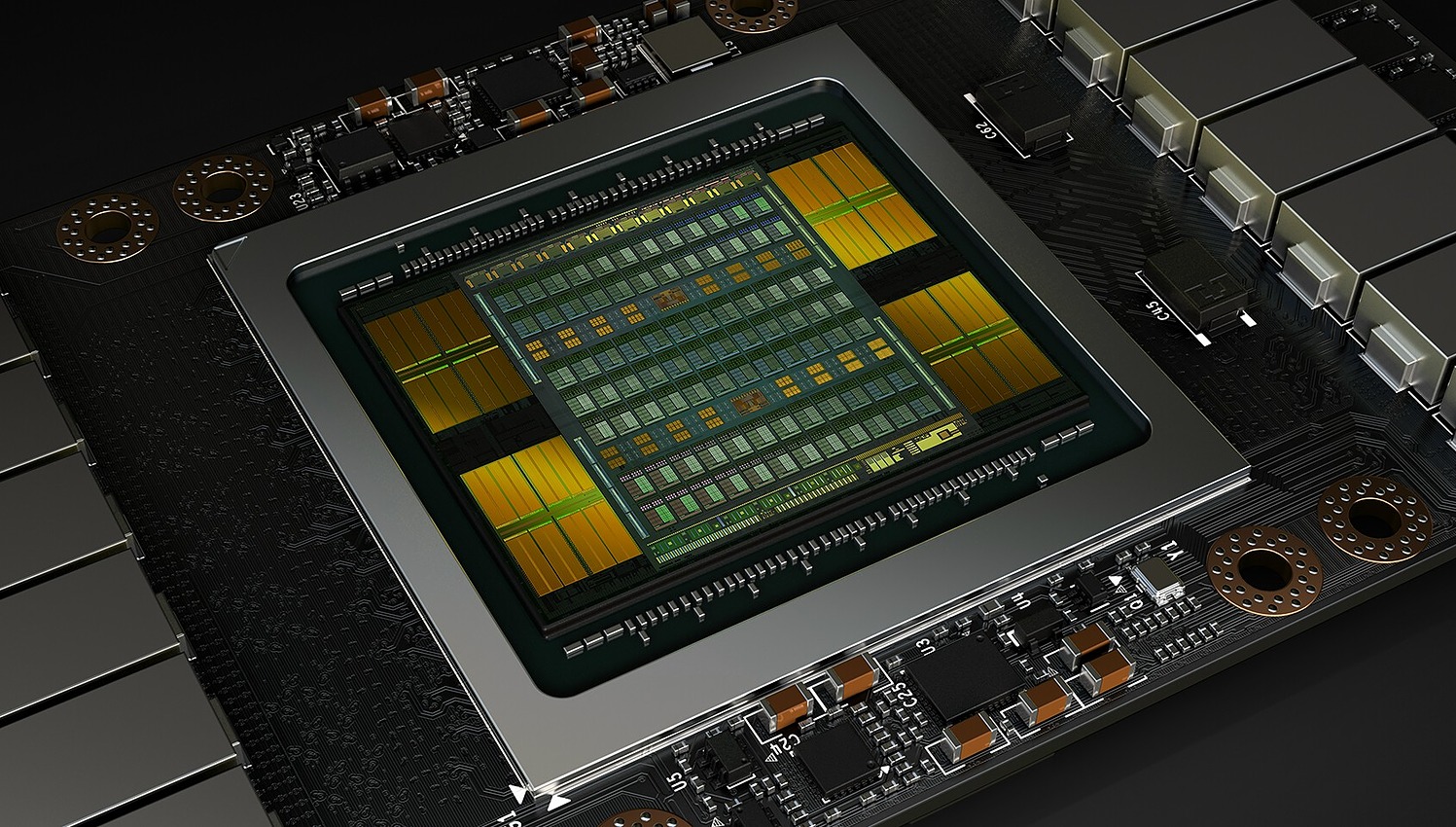

Un joli bébé.

Je ne sais pas pour vous, mais je trouve que cette photo est magnifique :

---------------

L'innovation, c'est extra :)

Marsh Posté le 11-05-2017 à 11:22:18 1

| Zurkum a écrit : Question : |

Je me suis posé la meme question. C'est vrai qu'a la base il n'y a pas enormement de contraintes pour la taille du die en dehors du yield (la proba que les GPU sur le wafer soient fonctionnels) qui diminue beaucoup en fonction de la taille du die

Mais les machines (la partie optique en particulier) sont dimensionnées afin de fabriquer des puces dont le yield ne sera pas trop faible donc pas trop enormes. Apres si un fabricant decide d'aller au dela, il est probablement possible d'adapter la chaine de production dans ce but.

Etant donne le marché visé (super computing, HPC, deep learning, etc), nVidia a peut etre decidé d'aller au dela de sa tolerance habituelle en matiere de yield pour ses prochaines generations de puces computing. Il est clair qu'une telle puce n'est pas viable pour une carte graphique (a moins qu'il y ait un marche pour des CG a 10000 euros ![]() ), mais comme depuis qques années les cartes computing ne sont plus basées sur les memes puces que les cartes graphiques, ca a un sens.

), mais comme depuis qques années les cartes computing ne sont plus basées sur les memes puces que les cartes graphiques, ca a un sens.

PS: je me demande quand meme si ils ne comptent pas la HBM dans la mesure de surface du GPU, sachant que la HBM n'est pas sur le meme die. clairement pas ![]()

PS2: apparemment les capteurs CMOS (pour la photo), notamment les full frame (830mm2) ou pire les "medium format" (jusqu'a 2000mm2), sont les plus gros chips semi conducteurs CMOS. Mais c'est un cas particulier et avoir qques pixel morts peut etre corrigé par une interpolation, permettant d'augmenter le yield

PS3: apparemment certains capteurs pour l'imagerie spatiale peuvent faire la taille d'un wafer ![]() https://www.teledynedalsa.com/imaging/products/sensors/

https://www.teledynedalsa.com/imaging/products/sensors/

Message édité par samurai80 le 11-05-2017 à 11:56:20

Marsh Posté le 11-05-2017 à 11:26:38 4

| Lyto a écrit : Un joli bébé. |

Ca rend pas mal oui mais ceci dit c'est un montage photoshop, ce n'est pas une photo de die !

Marsh Posté le 11-05-2017 à 11:27:37 2

| Lyto a écrit : Un joli bébé. |

Modélisation 3D ![[:aloy] [:aloy]](https://forum-images.hardware.fr/images/perso/aloy.gif)

Sujets relatifs:

- [HFR] Actu : Résultats Nvidia : +48% avec Nintendo et les datacenter

- [Topic Unique] Nvidia Volta ("12nm" FFN)

- [HFR] Actu : HardWare.fr a 20 ans !

- Nvidia Shield débit PC Gamestream

- Go ou Fréquence / asus P5Q-E en ddr2, best solution? Please.thx

- [HFR] Actu : GTX 1080 Ti aux hormones chez KFA2

Marsh Posté le 10-05-2017 à 22:37:48 0

Nvidia profite de sa GPU Technology Conference pour dévoiler quelques détails sur le GV100, le premier GPU de la génération Volta qui sera dédié au monde du ...

Lire la suite ...