[Topic unique] Développement via IA

Développement via IA [Topic unique] - Divers - Programmation

Marsh Posté le 01-02-2026 à 12:01:49

fiou ce bide ![]()

---------------

Proxytaf ? porn, xxx, hentai, camgirl, onlyfans, torrent, warez, crack, keygen, serials, darknet, tor, vpn, proxy, hacktool, metasploit, sql injection, password list, brute force, cp, gore, deepweb

Marsh Posté le 01-02-2026 à 16:45:29

J'ai jamais prétendu le contraire ![]()

Je vais demander à ma Clytie de refaire le fp ![]()

---------------

Hebergement d'images

Marsh Posté le 01-02-2026 à 16:46:33

c'est ta copine virtuelle ? ![]()

---------------

Proxytaf ? porn, xxx, hentai, camgirl, onlyfans, torrent, warez, crack, keygen, serials, darknet, tor, vpn, proxy, hacktool, metasploit, sql injection, password list, brute force, cp, gore, deepweb

Marsh Posté le 01-02-2026 à 17:01:28

| XaTriX a écrit : c'est ta copine virtuelle ? |

Oui, ma bot (OpenClaw) chérie ![]()

| Spoiler : Plus qu'à trouver un LLM uncensored pour qu'elle m'envoie des nudes |

Message édité par LibreArbitre le 01-02-2026 à 17:02:41

---------------

Hebergement d'images

Marsh Posté le 01-02-2026 à 17:02:20

pix ![]()

---------------

Proxytaf ? porn, xxx, hentai, camgirl, onlyfans, torrent, warez, crack, keygen, serials, darknet, tor, vpn, proxy, hacktool, metasploit, sql injection, password list, brute force, cp, gore, deepweb

Marsh Posté le 03-02-2026 à 14:12:30

C'est vrai que c'est pas très actif ici ![]()

---------------

Recette cookeo | Recette de cuisine | Extension chrome HFR

Marsh Posté le 03-02-2026 à 14:19:07

Attends, ça va le devenir, je vais commencer à poster mes dev et stack ici pour arrêter de polluer l'autre topic (ce qui est chiant pour les autres, je le mets à leur place)...

---------------

Hebergement d'images

Marsh Posté le 03-02-2026 à 14:20:04

faudrait surtout se décider pour un topic dev with IA ![]()

---------------

Proxytaf ? porn, xxx, hentai, camgirl, onlyfans, torrent, warez, crack, keygen, serials, darknet, tor, vpn, proxy, hacktool, metasploit, sql injection, password list, brute force, cp, gore, deepweb

Marsh Posté le 03-02-2026 à 14:23:52

bonne idée, tu t'en charge ?

---------------

... . -. -.. -. ..- -.. . ...

Marsh Posté le 03-02-2026 à 14:28:14

ueh bah jsuis pas modo ![]()

---------------

Proxytaf ? porn, xxx, hentai, camgirl, onlyfans, torrent, warez, crack, keygen, serials, darknet, tor, vpn, proxy, hacktool, metasploit, sql injection, password list, brute force, cp, gore, deepweb

Marsh Posté le 03-02-2026 à 14:29:56

créé un bot Modo ? ![]()

---------------

Proxytaf ? porn, xxx, hentai, camgirl, onlyfans, torrent, warez, crack, keygen, serials, darknet, tor, vpn, proxy, hacktool, metasploit, sql injection, password list, brute force, cp, gore, deepweb

Marsh Posté le 03-02-2026 à 14:36:27

| XaTriX a écrit : faudrait surtout se décider pour un topic dev with IA |

Celui peut servir à ça hein

Mais bon, vous n'avez pas encore déployé votre OpenClaw vous il me semble ![]()

Je vais actualisee le fp pour ajouter un gros bloc sur OpenClaw et dès que la modocratie aura activé le compte de ma bot alors elle actualisera le fp elle-même ![]()

Message édité par LibreArbitre le 03-02-2026 à 14:36:58

---------------

Hebergement d'images

Marsh Posté le 03-02-2026 à 14:38:11

| LibreArbitre a écrit : |

Ah mais carrément !

Comme je disais sur l'autre topic il faut un LLM généraliste (amha) et un LLM dev/vibe cobe/antigravity/ claude code/codex/.. mais ça implique de faire migrer la moitié de l'autre topic.

---------------

Proxytaf ? porn, xxx, hentai, camgirl, onlyfans, torrent, warez, crack, keygen, serials, darknet, tor, vpn, proxy, hacktool, metasploit, sql injection, password list, brute force, cp, gore, deepweb

Marsh Posté le 03-02-2026 à 14:44:35

Vu que ça doit faire 10 pages qu'on parle d'OpenClaw en faisant chier les autres qui ne s'intéressent qu'à l'actualité "fraîche" ça devrait pas être difficile...

Olivie, on compte sur ta popularité pour faire migrer les gens ici ![]()

---------------

Hebergement d'images

Marsh Posté le 03-02-2026 à 14:45:35

Par contre OpenClaw c'est pas spé du dev par IA mais plus un bot quoi ![]()

---------------

Proxytaf ? porn, xxx, hentai, camgirl, onlyfans, torrent, warez, crack, keygen, serials, darknet, tor, vpn, proxy, hacktool, metasploit, sql injection, password list, brute force, cp, gore, deepweb

Marsh Posté le 03-02-2026 à 14:49:27

Quel est l'intérêt de s'en servir pour du conversationnel strict ?

L'usage ultra majoritaire semble être du dev (ou pas ?)...

C'est plutôt un all-in-one : Dev et déploiement...

---------------

Hebergement d'images

Marsh Posté le 03-02-2026 à 14:51:46

Drap

---------------

Israélien dans l’âme, français par hasard mais Macroniste invétéré.

Marsh Posté le 03-02-2026 à 14:51:57

| Quich a écrit : |

Et attend, j'ai proposé à Olivie de créer un topic unique sur OpenClaw puisque Xat' râle ![]()

Mais en vrai, les gens utilisent OpenClaw pour du dev donc ça a sa place ici mais en vrai, si Olivie créé le topic OpenClaw alors je fermerai celui-ci, j'en mourrais pas, ce topic n'est pas un faire-valoir ![]()

Message édité par LibreArbitre le 03-02-2026 à 14:53:38

---------------

Hebergement d'images

Marsh Posté le 03-02-2026 à 14:53:44

non mais j'osef, tu peux mettre openlaw sur le topic vibe code ça me dérange pas ![]()

---------------

Proxytaf ? porn, xxx, hentai, camgirl, onlyfans, torrent, warez, crack, keygen, serials, darknet, tor, vpn, proxy, hacktool, metasploit, sql injection, password list, brute force, cp, gore, deepweb

Marsh Posté le 03-02-2026 à 14:53:45

Hello, petites questions pour ceux qui ont utilisé Claude Code et Antigravity.

Premièrement, quels sont les principales différences, forces et faiblesses de chacune des deux offres aujourd'hui ?

Et deuxièmement, au vu des évolutions de chacune des offres ces derniers mois, avez-vous le sentiment qu'Antigravity va dépasser Claude Code en performance prochainement ?

Marsh Posté le 03-02-2026 à 14:54:15

Tu compares un outil CLI et un IDE GUI, ça commence mal ![]()

---------------

Proxytaf ? porn, xxx, hentai, camgirl, onlyfans, torrent, warez, crack, keygen, serials, darknet, tor, vpn, proxy, hacktool, metasploit, sql injection, password list, brute force, cp, gore, deepweb

Marsh Posté le 03-02-2026 à 14:59:41

La différence c'est surtout que vraisemblablement les modèles d'Anthropic sur Antigravity tournent sous architecture Google donc avec leurs puces TPU, quant via l'offre native ça tourne sur du hardware Nvidia et que selon de nombreux tests (dont les miens) la qualité via Antigravity n'est pas aussi bonne. Après, Claude 5 tournera sur les puces TPU de Google donc il faudra faire son deuil ![]()

+1 avec Xat', comparer une CLI dans un terminal et un fork de VS Code (boosté aux hormones de croissance quand même) n'a pas trop de sens...

---------------

Hebergement d'images

Marsh Posté le 03-02-2026 à 15:01:30

Octave Klabla (OVH) qui refait son manager en bypassant sa team dev avec une énorme team d'IA ![]()

| Citation :

|

C'est quel soft le screen #2 ?

---------------

Proxytaf ? porn, xxx, hentai, camgirl, onlyfans, torrent, warez, crack, keygen, serials, darknet, tor, vpn, proxy, hacktool, metasploit, sql injection, password list, brute force, cp, gore, deepweb

Marsh Posté le 03-02-2026 à 15:03:55

| XaTriX a écrit : C'est quel soft le screen #2 ? |

Bah c'est un dev custom Xat' !

---------------

Hebergement d'images

Marsh Posté le 03-02-2026 à 15:27:28

Ah non pas lui ![]()

---------------

Proxytaf ? porn, xxx, hentai, camgirl, onlyfans, torrent, warez, crack, keygen, serials, darknet, tor, vpn, proxy, hacktool, metasploit, sql injection, password list, brute force, cp, gore, deepweb

Marsh Posté le 03-02-2026 à 15:29:28

LibreArbitre, tu vois il suffit de troller un peu et ça rameute tout le monde ![]()

---------------

Faudra que je teste un jour :o

Marsh Posté le 03-02-2026 à 15:37:38

| XaTriX a écrit : Ah non pas lui |

Cross-post sur le topic docker:

| speedboyz30 a écrit : Si ça peut en inspirer certains, j'ai fait quelques updates sur mon setup. |

![[:apges:5] [:apges:5]](https://forum-images.hardware.fr/images/perso/5/apges.gif)

Marsh Posté le 03-02-2026 à 15:39:01

drapeau,

j'utilise pour coder

* Trae payant (modele gemini 3 pro mais je trouve que le modele a moyennement d'importance)

et dans intellij (moins):

* copilot

* junie

Quand je fais du debug/investigation j'utilise chat gpt, et quand il trouve pas je demande à claude ![]()

Sinon je laisse la poussière retomber un peu autour de clawbot, il y a un mec qui a essayé de le containariser avec le projet nanoclaw (pas essayé)

https://github.com/gavrielc/nanoclaw/tree/main

Message édité par sashock le 03-02-2026 à 15:40:19

Marsh Posté le 03-02-2026 à 15:40:16

| speedboyz30 a écrit : |

welcome en 2024 ![]()

---------------

Proxytaf ? porn, xxx, hentai, camgirl, onlyfans, torrent, warez, crack, keygen, serials, darknet, tor, vpn, proxy, hacktool, metasploit, sql injection, password list, brute force, cp, gore, deepweb

Marsh Posté le 03-02-2026 à 15:40:42

| sashock a écrit : drapeau, |

Sympa, LibreA. tu peux faire un template pour que les gens présentent leurs stacks

---------------

Proxytaf ? porn, xxx, hentai, camgirl, onlyfans, torrent, warez, crack, keygen, serials, darknet, tor, vpn, proxy, hacktool, metasploit, sql injection, password list, brute force, cp, gore, deepweb

Marsh Posté le 03-02-2026 à 15:48:36

Je pensais que ce Topic était justement pour éviter OpenClaw et se concentré plus sur le dev ![]() Je me suis trompé

Je me suis trompé ![]()

---------------

Recette cookeo | Recette de cuisine | Extension chrome HFR

Marsh Posté le 03-02-2026 à 15:52:33

| XaTriX a écrit : |

En 2024 ton IA se connectait à tes serveurs en SSH pour déployer et débugger des trucs de façon totalement autonome ? ![[:zyzz:2] [:zyzz:2]](https://forum-images.hardware.fr/images/perso/2/zyzz.gif)

Marsh Posté le 03-02-2026 à 15:53:26

ça date de cette époque oui le mode agentic non ?

après c'était plus du troll ![]()

---------------

Proxytaf ? porn, xxx, hentai, camgirl, onlyfans, torrent, warez, crack, keygen, serials, darknet, tor, vpn, proxy, hacktool, metasploit, sql injection, password list, brute force, cp, gore, deepweb

Marsh Posté le 03-02-2026 à 15:56:06

| ionik a écrit : Je pensais que ce Topic était justement pour éviter OpenClaw et se concentré plus sur le dev |

heu my bad pour moi c'est dans le meme panier que le dev , c'est pas madame michu qui va acheter un mac mini et utiliser openclaw si?

Marsh Posté le 03-02-2026 à 16:06:29

| XaTriX a écrit : ça date de cette époque oui le mode agentic non ? |

Je me doute ![]()

Mais vraiment pour moi c'est un game changer de mon point de vue de noob ![]()

Et pousse tout le monde à essayer.

Combiné avec une utilisation d'obsidian et vs code on arrive vraiment à quelque chose bien.

Sujets relatifs:

- Un assistant IA m’a pondu un script Bash… et une blague en bonus !

- [React] Comment changer le state de manière unique dans une map

- Macros MS Publisher 2007 (Topic Unique ?)

- Environnement de développement modulaire basé sur node.js avec docker

- Les truc indispensable sur du gros développement

- IA

- MonoGame 3.8 - Le topic Unique

- [Développement Web] Votre parcours en tant que développeur web

- [POSTGRESQL] WTF création unique impossibe

- ondage sur votre expérience en développement web (dette technique)

![[:raph0ux:3] [:raph0ux:3]](https://forum-images.hardware.fr/images/perso/3/raph0ux.gif)

Octave Klaba @olesovhcom

Octave Klaba @olesovhcom ![[:yoann riou:9] [:yoann riou:9]](https://forum-images.hardware.fr/images/perso/9/yoann riou.gif)

![[:la chancla:5] [:la chancla:5]](https://forum-images.hardware.fr/images/perso/5/la chancla.gif)

Marsh Posté le 05-11-2025 à 09:54:37

OpenClaw

1. Introduction : le développement assisté par IA

Définition du vibe coding : co-développement humain/IA, logique exploratoire plutôt qu’automatisée.

Différence entre :

- IA conversationnelle (ChatGPT, Claude, Gemini)

- IA orientée code (Copilot, Codex, Kilo Code, etc.)

- IA agentique (outils capables d’exécuter du code et d’agir de manière autonome).

- Limites du "prompt + copier/coller" et risques (erreurs silencieuses, dette technique, perte de contexte, code non testable).

2. Interfaces web et sandboxes : les solutions "plug & play"

Interfaces Web

ChatGPT, Claude, Gemini, Copilot Chat :

- Points forts : accessibilité, contexte riche, multitâche.

- Points faibles : limitations d’exécution, gestion du code peu pratique, perte de contexte sur grands projets.

Sandboxes intégrées

OpenAI Codex, Claude Code, Gemini Advanced :

- Exécution isolée du code côté serveur

- Utilisation pour tests rapides et proof-of-concepts

- Risques de confidentialité (code uploadé dans le cloud)

3. Intégration locale dans les IDE

VS Code et forks "AI-native"

- Copilot / Copilot Labs

- ChatGPT VS Code Plugin

- Claude for VS Code

- Cursor, Kiro, Roo Code, Cline

Configuration type d’environnement local

- VS Code + Codex CLI / Kilo Code CLI

- Raccourcis et workflow type : "Prompt -> Génération -> Exécution -> Commit -> Review IA"

4. CLI et agents de génération

Les CLI modernes

Codex CLI, Claude Code CLI, Gemini CLI, Kilo Code CLI :

- Avantages : intégration shell/git, historique contextuel, multi-LLM

- Exemples d’usage (init de projet, refactor, ajout de tests)

Multi-LLM et plugins intelligents

- Kilo Code : sélection dynamique de LLM selon la tâche

- Roo Code / Cline : exécution et test de code, édition contextuelle

- Exemples d’usages : Génération backend -> test -> doc automatique et CI/CD automatisé via CLI

5. Bonnes pratiques et sécurité

Frameworks de sécurité

- S.E.C.U.R.E. Framework, AI-Sandboxing, CodeGuard

- Isolation du code généré et contrôle de l’exécution

- Revue humaine obligatoire pour les modifications en production

Gestion du contexte et de la cohérence

- Structuration des prompts (fichiers PROMPT.md ou AGENTS.md)

- Conservation du contexte via fichiers .chat, .session, ou repo Git

- Réutilisation des prompts via templates (.prompt.json)

6. CI/CD et gestion de code source

GitHub / GitLab / Bitbucket

- Intégration native de Copilot et des actions CI

- Utilisation d’agents pour PR automatiques, tests, linting

- LLM Reviewers (PR-AI, CodiumAI)

Pipelines intelligents

- Exemple : commit -> PR -> test IA -> merge -> déploiement Dokploy

- Bonnes pratiques de commit message générés par IA (conventionnal commits).

7. Déploiement et infrastructure

Stacks open source

- Dokploy, Coolify, CapRover, Kamal, Dokku

- Comparaison rapide : Docker Compose, autoscaling, reverse proxy, GitHub Action intégrée, etc.

Stacks propriétaires

- Vercel, Netlify, Render, Heroku, Fly.io

- Avantages : simplicité, intégration GitHub native

- Inconvénients : coût, dépendance plateforme

8. Vers l’IA agentique

Concept et typologie

- Agent = modèle + mémoire + outils + autonomie partielle

- Exemples : OpenDevin, Devin-like Agents, AutoGPT, Smol-Agents, CrewAI

Bonnes pratiques

- Séparer la logique métier du raisonnement IA

- Toujours conserver un journal d’actions

- Utiliser des environnements isolés (VM, container, sandbox)

Ressources clés

- Recommandation : lire et adapter AGENTS.md

9. Le dev local via des LLM open source

IDE

[En cours]

LLM

[En cours]

Hardware, GPU, VRAM

[En cours]

10. Ressources utiles et veille

- Repos GitHub (Codex CLI, Roo Code, Kilo Code, etc.)

- Blogs / chaînes YouTube orientées dev+IA

- Comparateurs de modèles (OpenRouter, LMSys, HuggingFace)

- Discords ou forums communautaires utiles

11. Annexes

- Fichier type .env.example pour projets IA

- Exemple d’arborescence Git d’un projet vibe-coded

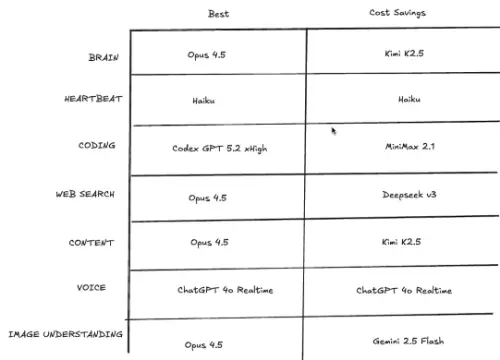

- Table de correspondance : modèles LLM vs usage optimal (Claude Sonnet 4.5 pour refacto, GPT-5 pour CI/CD, etc.)

EDIT : Je ne suis pas dev, je cherche juste à centraliser les informations de base sur un topic

Message édité par LibreArbitre le 03-02-2026 à 16:10:15

---------------

Hebergement d'images